[2405.14371] EdgeShard: Efficient LLM Inference via Collaborative Edge Computing (arxiv.org)

摘要

大型语言模型(LLMs)在自然语言处理和内容生成方面显示出巨大的潜力。然而,目前的LLM严重依赖云计算,导致延迟延长、带宽成本高和隐私问题。边缘计算有望通过在更靠近数据源的边缘设备上部署LLM来解决这些问题。一些工作试图利用模型量化来减小模型大小以适应资源约束的边缘设备,但这会导致精度损失。其他作品使用云边缘协作,遭受网络连接不稳定的困扰。在这项工作中,我们利用协作边缘计算来促进边缘设备和云服务器之间的协作,以共同执行高效的LLM推理。我们提出了一个通用框架,将LLM模型划分为分片并部署在分布式设备上。为了实现高效的LLM推理,我们制定了一个自适应的联合设备选择和模型划分问题,并设计了一个高效的动态规划算法来分别优化推理延迟和吞吐量。在异构物理原型上对Llama2串行模型的实验表明,EdgeShard比基线方法实现了高达50%的延迟降低和2倍的吞吐量提高。

背景

大模型的特点

大模型体积大、计算复杂度高,对存储和算力有着较高的需求,计算密集、资源贪婪

- 体积大:大模型起码具有10亿以上的参数,需要占用几十GB甚至几百GB的存储空间

- 计算复杂度高:

- LLM使用自回归的思想,注意力的计算复杂度是序列长度的平方O(T2)

- LLM层数多、参数大,对算力要求高

基于以上原因,现有的LLM主要部署在云服务器上,依托其大容量的内存和强大算力的GPU进行推理

云部署的缺陷

- 高延迟,响应时间长:终端设备与云需要进行通信,可能会存在较高的延迟(主流应用延迟并不明显,高峰期会有明显延迟)

- 带宽消耗大:将文本、视频、图像、音频、传感器数据等大量数据传输到云服务器,导致大量带宽消耗,给网络架构带来巨大压力

- 数据隐私问题:避免个人隐私成为训练数据而泄露

一种解决方案

边缘计算可以解决上面的缺陷。 将LLM部署在边缘设备,缩短数据和计算的距离,减少终端和云的数据通信量,避免了敏感数据泄露的风险

LLM采用边缘计算方案的挑战

LLM本身体积大、激活内存也大、KV Cache随序列长度不断增大,单个边端设备会OOM

现有方案:利用模型量化来减少模型体积以完整部署在单个边缘设备

存在问题:量化必然会降低模型精度(较小的损失是可以接受的),许多模型就算量化后也很大

现有方案:云边协同,微调或模型拆分

存在问题:边缘设备和云服务器的延迟通常很高且不稳定

新的方案:协同边缘计算

背景前提:边缘计算能力的持续增长留下了大量资源可供使用

存在问题:边缘计算现在主要关注云、边、端的垂直协同,而横向的边缘协作存在资源利用率未优化、业务覆盖受限、性能参差不齐等问题

解决方案:EdgeShard

环境特点:计算是异构的、带宽是低的,导致为云数据中心设计的LLM部署方案无法直接应用在边缘计算环境

提出一种通用LLM通用框架,分布式计算设备上自适应设备选择和LLM划分,解决高内存需求,并优化推理

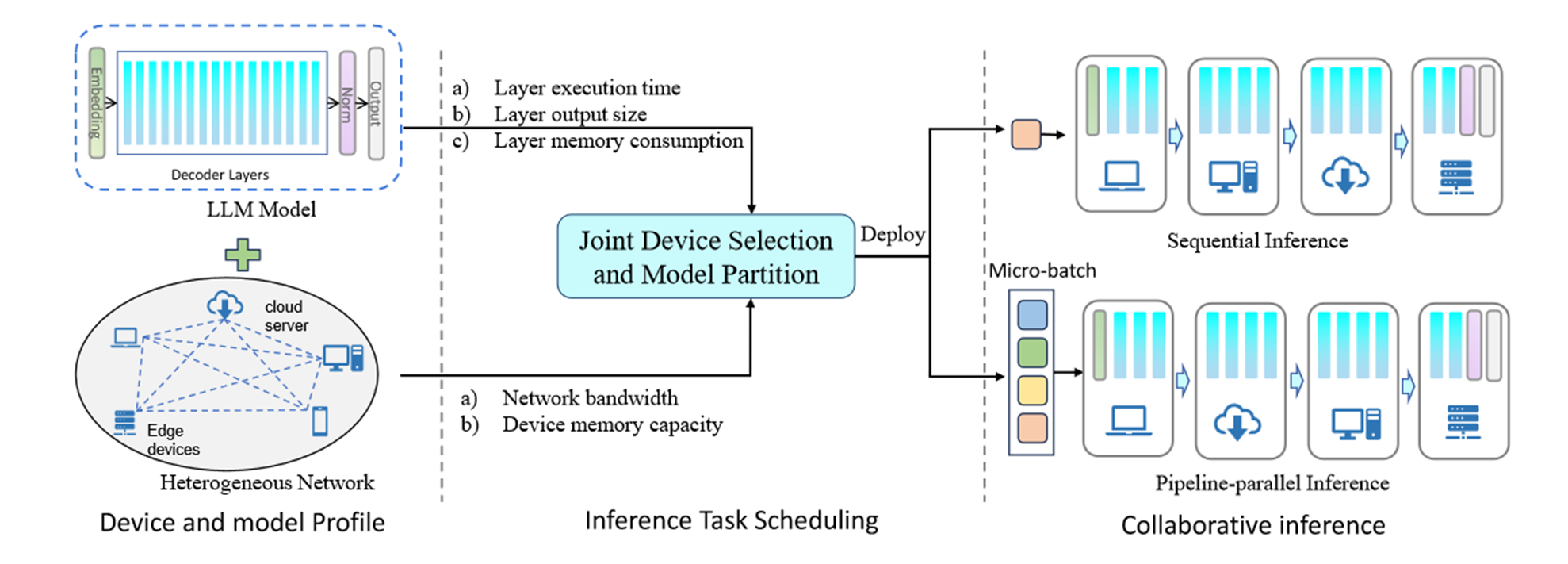

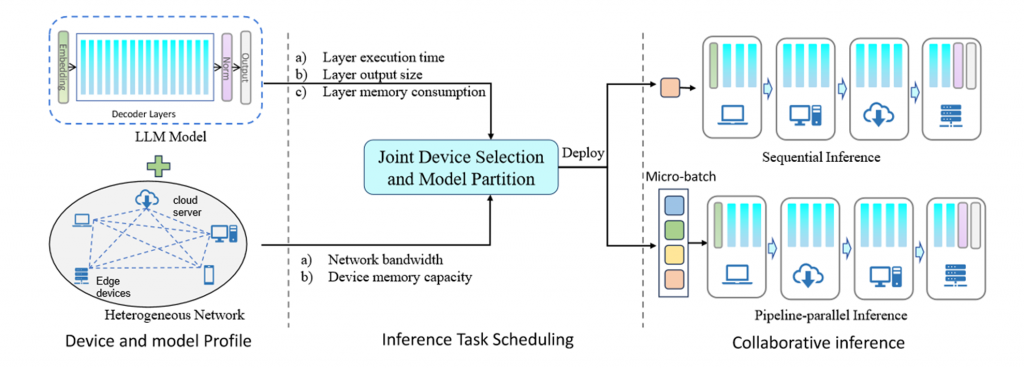

EdgeShard架构

离线分析

只需执行一次,获取相关信息

- 每个层在不同设备上的执行时间

- LLM模型的每一层的激活的大小和存储器消耗

- 每个设备的可用存储器和设备之间的带宽。

对于每一层的执行时间,分别在预填充阶段和自回归阶段分析生成令牌的时间,并取平均值。

对于那些可能没有有效内存来保存完整模型以执行评测的设备,我们使用动态模型加载技术,其中模型层被连续加载以适应受约束的内存。

任务调度优化

确定参与设备、如何分层划分模型、模型碎片分配给哪个设备

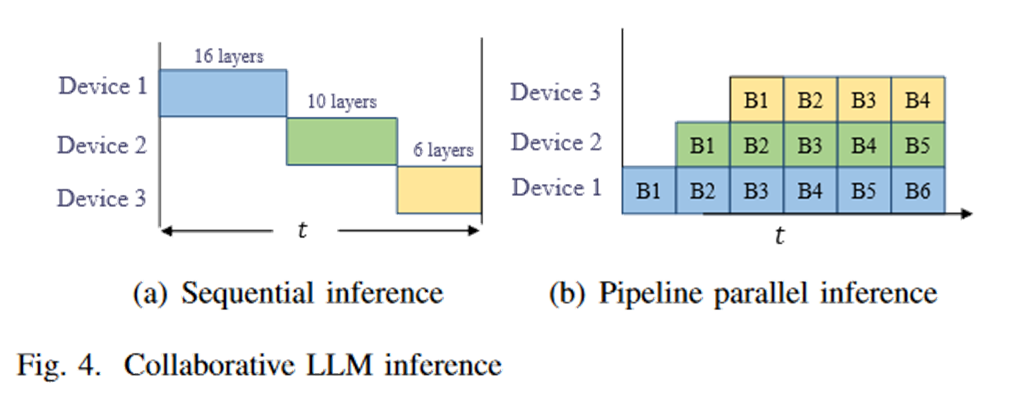

考虑了顺序推理和流水线推理两种模式

优化延时或吞吐量

协同推理

在每个参与的设备上为KV Cache缓存预先分配空间

相关工作

量化

- GPTQ 量化(权重量化)

- 优化信道缩放以保留显著的重要权重来减少量化误差(权重量化)

- SmoothQuant(模型激活量化)

- Agile Quant(模型激活量化)

云边协作

将来工作

- 激励机制促使边缘设备参与计算

- 没有考虑batch size的影响

不足之处

- 离线计算阶段的结果与边缘环境和模型相关、batch相关,当环境或模型发生变化时,需要重新进行计算,要仔细考虑计算复杂度的影响

- 没有完全做到自适应,边缘设备之间仍然存在不稳定带宽和设备在线状态不稳定的情况

- 在带宽质量较高的情况下,边缘协同和云边协同基本没有差距

- 没有考虑更细粒度的内存管理,KV Cache的空间分配是固定的,每一层的稀疏性

优点

- 边缘协同的开创性工作