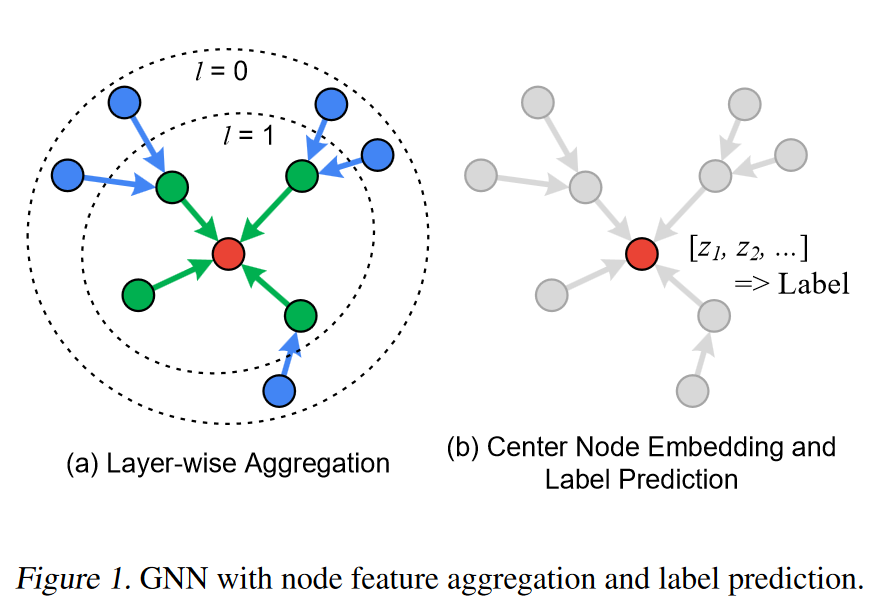

图神经网络借助图强大的数据表示能力和神经网络参数共享、局部连接和强大的拟合能力在社交网络分析、推荐系统、分子预测等多种领域取得了很好的效果,飞速增长的数据规模给图神经网络系统带来了可扩展性的问题。尤其是图中节点之间不规则的连接在基于采样的GNN训练中导致了节点的冗余访问,相较于图拓扑数据而言庞大的特征数据在不同的节点或设备之间的传输导致的通信效率低…

不同图采样模式的区别 minibatch SGD是在GPU内存优先的前提下将GNN训练扩展到更大规模数据集上的有效训练方式,然而对于每个minibatch中的目标节点,如果使用它的全部K阶邻居节点的聚合特征来生成该节点的嵌入表示,那么minibatch子图中节点的数量会随着K的增大而急剧增加,导致GPU内存无法容纳一个子图的特征数据,这就是GNN训…

GitHubzhiqi-0/Pagraph PaGraph由来自中科大李诚教授团队的林郅琦主导实现,该工作共发表在SoCC'20和TPDS'21上,代码已开源。 PaGraph的主要工作是在GNN系统中引入了特征缓存来加速训练并提供了一种简单可行的缓存策略;同时设计了一种图分区算法以支持对GPU的可扩展性。 背景知识 GNN 图是一种表示能力…